Motivation

NMT方法效果很好,但也有局限性:

NMT使用 Recurrent 架构,是 non-Markov 的。因此不能使用 DP 的方法并且限制了对全局特征或约束的利用。

目标端的句子内部的 inter-dependencies 没有考虑

可以将解码的不连续优化过程转化成连续优化问题来解决这些局限性

Methods

Continuous Optimisation

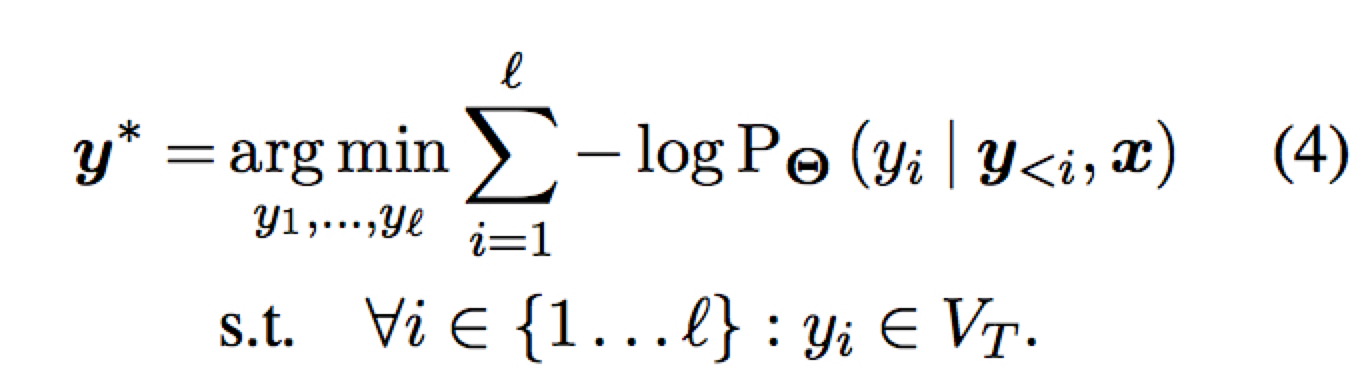

解码的优化问题可以如下一步步转化:

变为

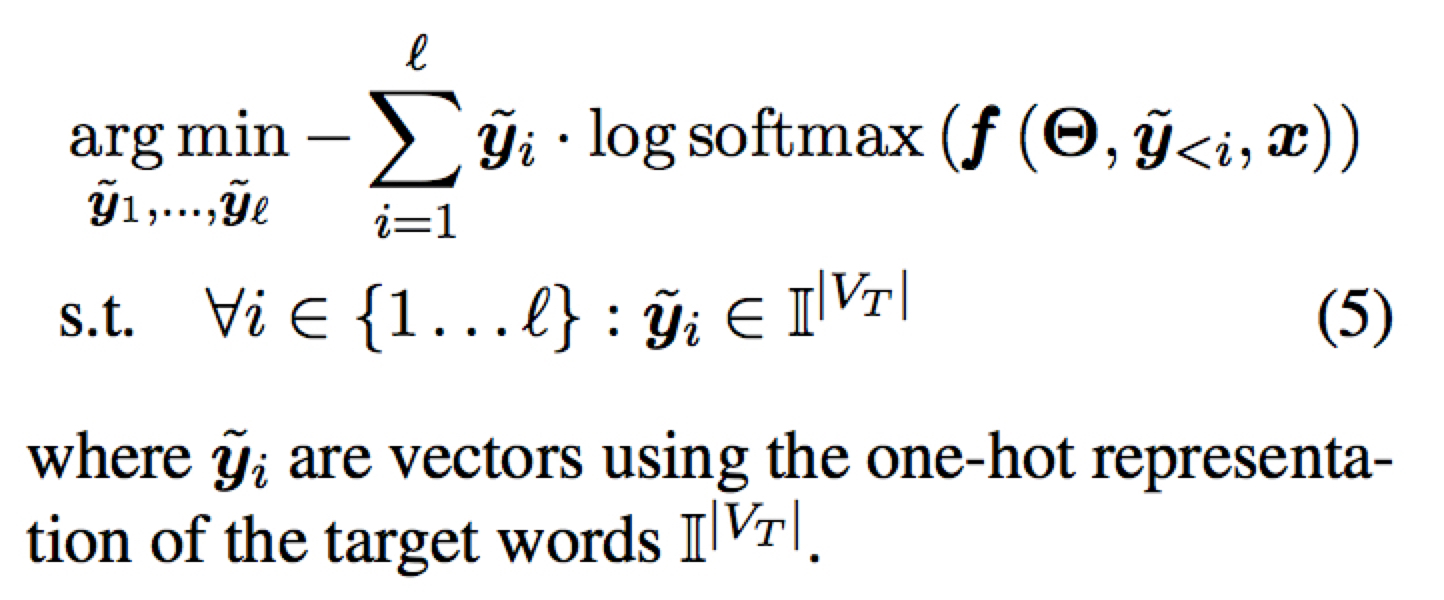

这时由于 y 是一个 one-hot 向量,因此限定了该优化问题为离散优化问题

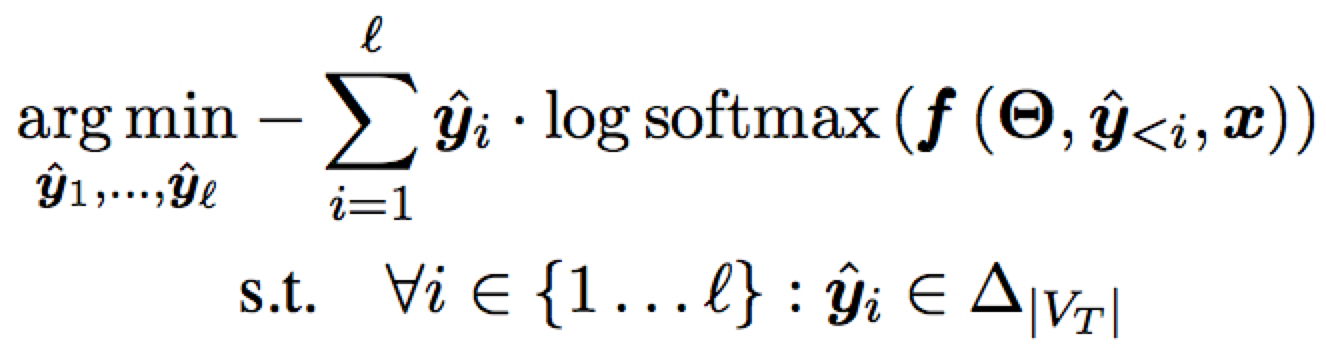

修改 y 的约束,从一个 one-hot 变为一个 n维 probability

simplex,即总和为1的向量

这时离散优化就转化为了连续优化。这一步直观上看可以解释为将 $y_i$ 的 embedding 变为在 $\hat{y}_i$ 分布下的 embedding 的期望 $E_{\hat{y}_{i}(w)}\left[\mathbf{E}^{w}_{T}\right]$

之后取 argmax 即为解码的词 token

Exponentiated Gradient (EG)

EG 是一种解决有关 simplex 约束优化问题的有效算法。其本质是最小化一个有关 simplex 约束的梯度下降算法。